どうも。フロントエンジニアやっている僕です。

弊社には「書籍購入補助制度」があり、各々がこの制度を利用してスキルアップに勤しむ。

素晴らしい会社だ。

たぶん。

ブログに書くネタにも事欠かない。

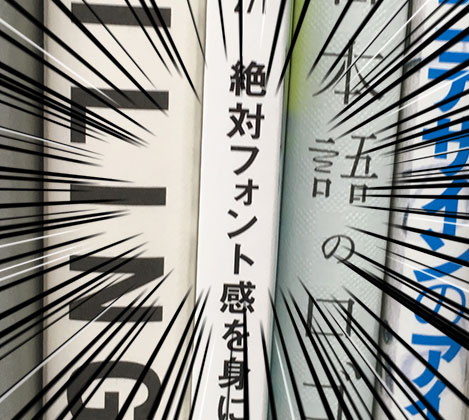

この本を見てほしい。

「絶対フォント感」

なんかよくわかんないけどかっこいい。

文字を見ただけで何のフォントを使用しているかわかる能力らしい。

これはすごい能力だ。

想像してみてほしい。

意中の女性と初めてのデートで、あなたは見栄はってワインをボトルで注文した。

このワインの種類なんかわからない。

話も途切れ途切れだ。

そんな時、あなたに「絶対フォント感」があったらどうなるか。

あなたの口からはごく自然にこう出てくる。

「このワインのラベルに使われているフォントはフランスの伝統的なロンド体だね。フランスワインにフランスのフォント。こだわりを感じるなぁ。あ、ちなみにこれはLino Scriptって名前ね!」

「かっこいい!抱いて!」

~Fin~

となるか知らんがとにかく響きがかっこいい。

身につけねばならない。

私はエレガントな男になりたいのだ。

なにより外に出れば文字だらけだし、お金も時間もかからない。エレガントな男はエコなのである。

さあ、外に出よう。

その一歩がエレガント。

ポイ捨てサイン

ビルを出ると早速エレガントへの道が開かれていた。中央区役所・作「ポイ捨てサイン」だ。

私にはMdN2016年11月号の付録、665書体も載っている見本帳を持っている。

恐れることはない。

どれどれ。

- 太さが同じで角が尖っている

- 「き」の3画、4画目が離れている

- 「は」が跳ねてない

- 「こ」が「クィン」ってなってる

- 「ポ」の2画目が跳ねてない

これをキーワードに探していく。

- 太さが同じで角が尖っている

これは「ゴシック体」というやつだ。ふむ、ゴシック体だけで29P。

つれぇわ・・・。

64P、ついに見つけた、お前か!!

モリサワフォントの「新ゴ」。たぶん合ってる。

これを見つけたら「このサインのフォントは、モリサワ社のゴシック体アップデート系・「新ゴ」ですぜ!」と言ってやりましょう。

僕はただ微笑され「へー」で終わりましたけど。

まだエレガントな男になれてないからね。しょうがないね。

散水栓

お次に出会ったのは散水栓。外の水まきなんかに使う用。らしい。

分析

- 丸くなってて、跳ねがない

- のぶん(散の部首)の箇所がちょっと離れてる

- 「水」の「フ」と「l」の間にスペースアリ

- 「栓」の「王」の上二つの横線が揃ってる

あと、一番の特徴は「栓」のデザインが「入」みたいになってる箇所だ、こんなの見たことない。

どれどれ。「丸ゴシック体」ってカテゴリーに絞って調べてみますかね。 私には見本帳がある。恐れることはない。

どれどれ。

どれどれど・・・・

参った、一つも該当する漢字が載ってない。

2つ目で挫折するわけにはいかない。任意の文字で確認できるフォントメーカーのサイトも駆使して力作業でねじ伏せてやる。

どれどれ。

ない!

「散」も「水」もニアピンで歯がゆいところまで来てる気がするのだが、「栓」が全然ない。上が「入」みたいになってるフォントは一つもない。「王」の上二つの横線が揃ってるのもない。

Googleで検索だ。迷ったらすぐ検索。

「栓 入 漢字」っと・・。

・

・

・

Google >「それ旧字やで^^」

現行常用漢字の「全」「栓」は、旧字体は上部が入屋根(いりやね)ですが、現在使われている新字体は人屋根(ひとやね)。一方、今回追加される「詮」は入屋根のままです。表外漢字字体表もこの形で掲げており、JIS2004で「詮」の例示字体が人屋根から入屋根に変更されました。改定常用漢字表は「詮」の人屋根の字体を「デザイン差」には掲げておらず、この字の印刷文字は入屋根で設計しなくてはなりません。

「人屋根←→入屋根」の揺れは、「詮」以外でも日常生活のなかで時々見かけているはずです。さすがに「全」は当用漢字以来の表内字なので新字体(人屋根)が広く定着していますが、「栓」は1981年に常用漢字入りした95字のひとつで歴史が浅い?ため、今でも駅などの「消火栓」の表示で旧字体(入屋根)が使われていることがあります。

「改定常用漢字表」解剖 5 - ことばマガジン:朝日新聞デジタル

漢字面倒すぎるだろ、いい加減にしろ。

4時間ほど調べてみたがお手上げだ。

わからないことをわからないと認めるのもまた勇気。

エレガントな男は挫けない。

次のサインを探し再び歩き始める。